Verzerrung – Eine Geschichte voller Missverständnisse

Wenn über Verzerrung gesprochen wird, hat man meist ihre bekannteste Form im Kopf, die bei HiFi ironischerweise aber kaum eine Rolle spielt. Das Phänomen besitzt aber noch viele weitere elektrische, mechanische und akustische Facetten.

Illustration: Ralf Wolff-Boenisch

Bringen Sie einen Musiker mit einem HiFi-Entwickler an einen Tisch und bitten Sie beide, den Begriff Verzerrung zu erläutern. Die Gesprächspartner werden Ihnen wahrscheinlich vollkommen unterschiedliche Ansätze präsentieren. Während der erste, der Musiker, ein gesundes Maß an Sättigung klasse findet, wird der andere, unser Entwickler, sein gesamtes Tun und Handeln unter das Banner der Vermeidung stellen. Musikmachen und -hören sind zwei unterschiedliche Welten, könnte man nun folgern. Doch korrekter wäre es, sich einfach einzugestehen, dass Verzerrung deutlich mehr Betrachtungswinkel zulässt, als man meinen sollte und auch kein grundsätzlich „schlechtes“ Phänomen darstellt.

Schon ihre Definition ist so grundliegend wie vage: Von Verzerrung ist immer dann die Rede, wenn das Original in irgendeiner Form verfälscht oder bewusst verändert wird. Es ist also vollkommen egal, ob die Verzerrungen bereits während der Aufnahme oder erst viel später bei der Wiedergabe auftreten. Außerdem können sie elektrische, mechanische sowie akustische Ursachen haben. Und schließlich sind nicht nur Frequenzen davon betroffen, sondern auch Amplituden und – besonders pikant! – das Timing. Um die Bandbreite des Begriffs darzulegen sehen wir uns die Teilaspekte nacheinander an.

Satt und verbogen

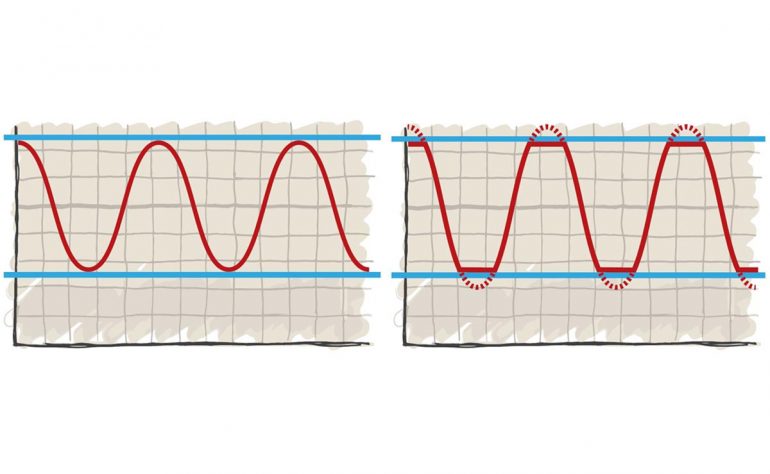

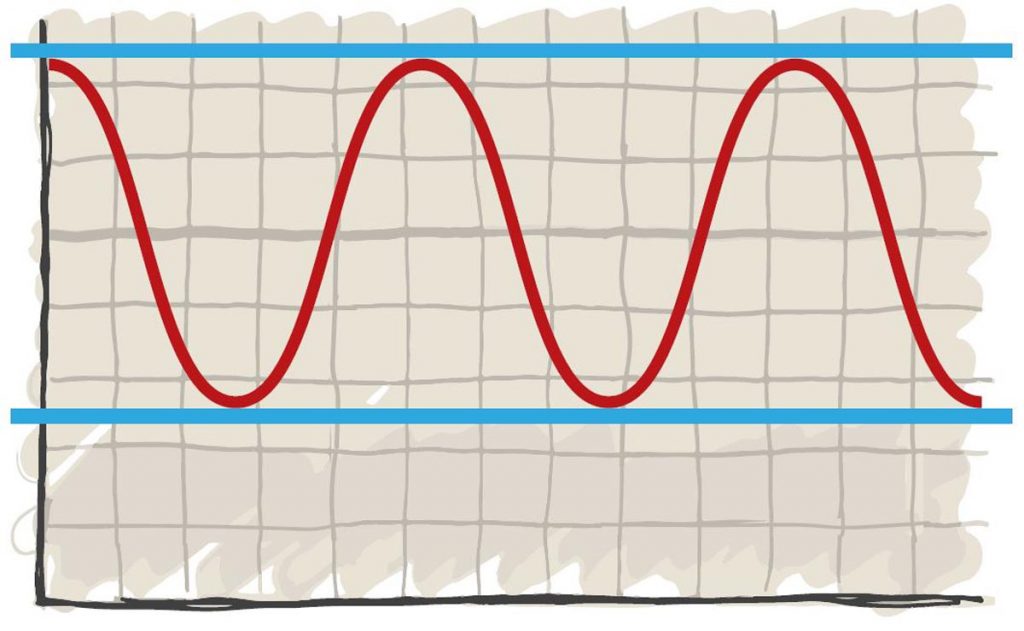

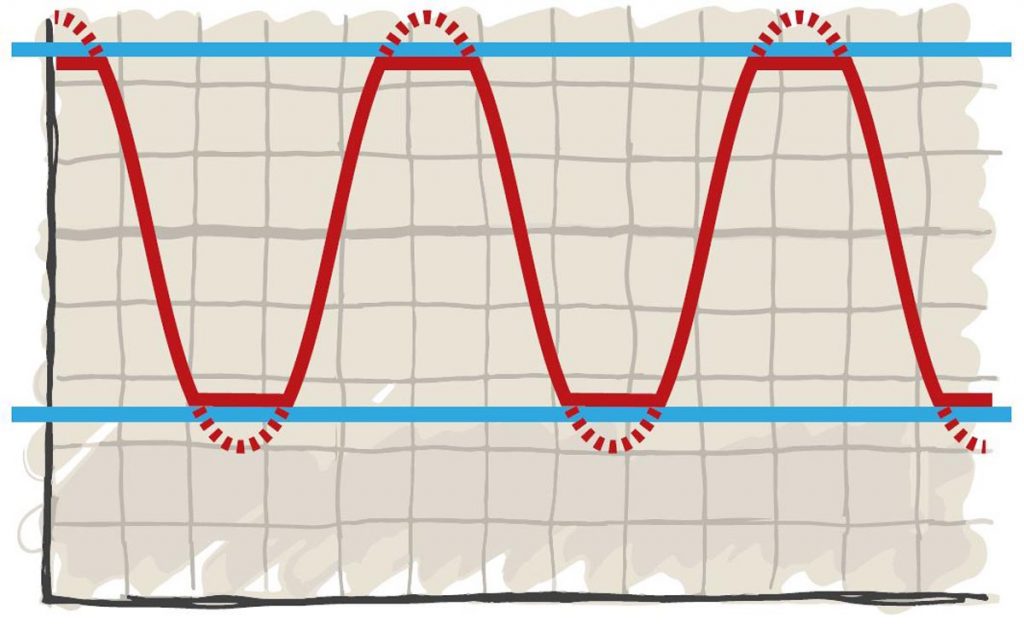

Die mit Abstand bekannteste Inkarnation der Verzerrung ist die Sättigung. Das liegt vor allem daran, dass sie ein essenzieller Bestandteil der zeitgenössischen Musikerzeugung ist. Jeder Schaltkreis hat eine Belastungsgrenze. Wird die vom Eingangssignal überschritten, kommt es zum Clipping (Abb.). Die Pegelspitzen werden abgeschnitten, in der Folge es entstehen zusätzliche Obertöne, die auf der Grundfrequenz des Originals beruhen können (harmonische Verzerrungen) oder nichts damit zu tun haben (inharmonische Verzerrungen). Clipping begrenzt also den Dynamikumfang des Signals und fügt Frequenzanteile hinzu. Rock- und Blues-Gitarristen möchten dieses Phänomen nicht missen, da die Übersteuerung den charakteristischen Sound ihrer Instrumente definiert. Produzenten sättigen bisweilen sogar den gesamten Mix, weil ihn das reichhaltiger, dichter und schmutziger tönen lässt und ein Gefühl von Power hinzufügt.

Im Umfeld von HiFi hat Clipping dagegen nichts verloren und eigentlich stellt es auch kein Problem mehr dar. Die meisten Geräte halten die für ihr Umfeld vorgegebenen Bezugspegel ein und vertragen sich miteinander. Geräte, die sich bewusst oder versehentlich übersteuern ließen (Bandmaschine, Tape-Deck etc.) sind praktisch verschwunden. Ein winzige Nische bilden Röhrenverstärker, die eine meist geplante und wohldosierte Nuance harmonischer Verzerrungen einbringen, um crisper und obertonreicher zu musizieren. Interessanterweise assoziieren wir ihren oft helleren und klareren Charakter mit „analoger Wärme“.

Viel häufiger sind wir mit der Verzerrung beziehungsweise Verformung des Frequenzgangs konfrontiert. Und kann den tonalen Charakter der Wiedergabe verändern. Naturinstrumente wie ein Klavier oder Violinen erzeugen obertonreiche Klänge, deren Frequenzen bisweilen über unser Hörvermögen hinausreichen. Die Bandbreite von Heim- und Studioelektronik wird hingegen absichtlich begrenzt, um hochfrequente Störungen fernzuhalten. Typisch ist heute ein Frequenzumfang von 20 Hertz bis etwa 50 Kilohertz. Höher reichen nur wenige Geräte. Die Auflösung zeitgemäßer Datenformate tut ihr Übriges: Ein Digitalsignal kann maximal Frequenzen transportieren, die der Hälfte seiner Taktrate entsprechen. Bei der CD-Audio (44,1 kHz) sind das beispielsweise 22,5 kHz. Das sei grundsätzlich kein Problem, sagen Akustiker und Entwickler, da das Hörvermögen junger Erwachsener im Mittel „nur“ von 20 Hz bis 20 kHz reicht. Tatsache bleibt jedoch: Die Natur des Schalls lässt sich mit gängiger Elektronik und Digitaltechnik weder vollständig einfangen noch reproduzieren.

Ein weiterer Auslöser für Frequenzgangverzerrung liegt im Charakter elektrischer und mechanischer Bauteile. Das greifbarste Beispiel dafür sind Lautsprechermembranen. Die können aufgrund ihrer Beschaffenheit jeweils nur einen bestimmten Frequenzbereich verzerrungsfrei abbilden. Um unerwünschte Störung zu vermeiden, begrenzt die Frequenzweiche die Bandbreite der Chassis. So wird jeder Treiber nur mit jenen Frequenzanteilen „beliefert“, die er auch problemlos reproduzieren kann. Die unterschiedlichen Wege (beziehungsweise Chassis) müssen freilich sauber ineinandergreifen, damit es nicht zu Frequenzlöchern oder Überlappungen kommt, die den Klang und Charakter der Wiedergabe verfärben könnten.

Auch bei diesen Verzerrungen ist es schwierig mit Begriffen wie „unerwünscht“ oder „schlecht“ zu argumentieren. Es gibt prominente Beispiele, in denen Manipulation sogar hilfreich ist. Etwa, wenn ein Loudness-Equalizer mehr Fundament und Transparenz in leise Pegellagen zaubert. Mancher Lautsprecher hat so einen Präsenz-Booster ab Werk eingebaut, indem er die oberen Mitten oder Höhen minimal betont und klingt damit richtig gut. Oder nehmen wir die Schallplatte. Die ist mechanisch ungeeignet, um tiefste Frequenzen zu transportieren. Die Nadel würde bei zu lauten Bassimpulsen einfach aus der Rille springen. Daher wird schon bei der Aufnahme gefiltert beziehungsweise verzerrt. Der Phono-Vorverstärker gleicht diesen bewussten Frequenzfehler aus und wird deshalb gern auch „Entzerrer“ genannt.

Aus dem Tritt geraten

Die vielleicht folgenreichste Form von Verzerrung geschieht auf der Zeitachse. Wie man sich leicht vorstellen kann, ist Luft zu träge, um komplexe Schwingungen zu transportieren. Schall setzt sich daher aus zahllosen sehr einfachen Sinusfrequenzen zusammen, die sich im Raum als Luftdruckschwankungen ausbreiten, sich überlagern, mit ihren Druckunterschieden gegenseitig beeinflussen. Aus diesem Zusammenspiel formt sich ein komplexes Ganzes mit individuellem Charakter. Leitet man diese Frequenzen auf elektronischer Ebene durch ein Filter, werden ihre Phasen um einen festen Betrag verändert beziehungsweise verzögert. Da hohe und niedrige Frequenzen jedoch sehr unterschiedliche Wellenlängen besitzen, verändert das auch den zeitlichen Bezug der Frequenzen. Summieren sich diese Verzögerungen auf, klingt die Wiedergabe nicht nur lahm und undefiniert, sie wird durch die neu zusammengewürfelte Beziehung ihrer Frequenzen auch tonal verändert. Dagegen hilft nur die solide Konstruktion und Planung von Weichen oder den Baugruppen der Wiedergabegeräten. Da tiefe Frequenzen absolut gesehen stärker von Verzögerungen betroffen sind, versucht ihnen mancher Boxen-Entwickler einen Vorsprung zu verschaffen, indem er seine Schallwände schräg angeordnet oder die Tweeter etwas vertieft ins Gehäuse baut. Einen großen Vorteil haben aktuelle Aktivmonitore mit ihrer oft digitalen Signalverarbeitung. Hier kommen meist phasenlineare Filter zum Einsatz, bei denen diese Timing-Probleme erst gar nicht auftreten.

Vor allem Bassmembranen können Ursache für ein weiteres mechanisches (und am Ende auch tonales) Erscheinungsbild der Verzerrung sein. Sie sind meist recht groß. Das macht sie vergleichsweise schwer und träge. Regt man einen Basstreiber mit einem kurzen Impuls an, stoppt er nicht sofort wieder ab, sondern schwingt kurz nach. Die angeregten Frequenzen mischen sich dadurch sprichwörtlich unter die folgenden Klänge und beeinflusst deren Charakter. Im schlimmsten Fall – der zum Glück nur äußerst selten vorkommt – führt das zu einem hörbaren Rumpeln und Dröhnen im Tiefton. Sehr viel häufiger ist es allerdings der Hörraum, dessen Reflexionen Nachschwinger verursachen, die den Charakter der Wiedergabe verändern und damit ebenfalls ein Aspekt von Verzerrung sind. Die Raumakustik ist allerdings eine Welt für sich, der wir uns an geeigneterer Stelle widmen wollen …

Mehr TechTalk? Hier geht’s lang …